Info- U2 teoría de la información

0.0(0)

Card Sorting

1/24

Earn XP

Description and Tags

estudiando para el parcial

Study Analytics

Name | Mastery | Learn | Test | Matching | Spaced |

|---|

No study sessions yet.

25 Terms

1

New cards

Símbolos y Datos

* Símbolos: Representaciones gráficas que se utilizan para comunicar información. Los símbolos pueden ser imágenes, signos, letras, números o cualquier otro elemento visual que tenga un significado específico.

* Datos: Hechos o estadísticas que se recopilan y se analizan para obtener información. Los datos pueden ser numéricos o no numéricos y se utilizan para tomar decisiones informadas en una variedad de campos, como la ciencia, la tecnología, los negocios y la política.

* Datos: Hechos o estadísticas que se recopilan y se analizan para obtener información. Los datos pueden ser numéricos o no numéricos y se utilizan para tomar decisiones informadas en una variedad de campos, como la ciencia, la tecnología, los negocios y la política.

2

New cards

Datos

Los datos son representaciones simbólicas de entes, hechos, atributos, etc. que se pueden transmitir, almacenar y transformar. Los datos son la materia prima para la creación de información y pueden ser utilizados para tomar decisiones informadas en una variedad de campos. Para que los datos sean útiles, deben ser organizados y analizados para extraer información significativa.

Los datos tienen la propiedad de que se pueden transmitir para llevarlos de un lugar a otro o para comunicárselos a alguien, almacenarlos para su posterior uso y transformarlos operando sobre ellos con ciertas reglas para obtener nuevos datos.

Además, se destaca que no todos los datos constituyen información. Para que los datos se conviertan en información útil, deben ser interpretados y asignárseles un significado específico por parte de quien los recibe e interpreta. De esta manera, **los datos se convierten en información cuando contribuyen a disminuir la incertidumbre y permiten tomar una decisión con el menor riesgo posible.**

En resumen, los datos son representaciones simbólicas que pueden ser transmitidas, almacenadas y transformadas mediante ciertas reglas para obtener nuevos datos. Para convertirse en información útil deben ser interpretados y asignárseles un significado específico por parte de quien los recibe e interpreta.

Los datos tienen la propiedad de que se pueden transmitir para llevarlos de un lugar a otro o para comunicárselos a alguien, almacenarlos para su posterior uso y transformarlos operando sobre ellos con ciertas reglas para obtener nuevos datos.

Además, se destaca que no todos los datos constituyen información. Para que los datos se conviertan en información útil, deben ser interpretados y asignárseles un significado específico por parte de quien los recibe e interpreta. De esta manera, **los datos se convierten en información cuando contribuyen a disminuir la incertidumbre y permiten tomar una decisión con el menor riesgo posible.**

En resumen, los datos son representaciones simbólicas que pueden ser transmitidas, almacenadas y transformadas mediante ciertas reglas para obtener nuevos datos. Para convertirse en información útil deben ser interpretados y asignárseles un significado específico por parte de quien los recibe e interpreta.

3

New cards

Información

**Información** como todas aquellas representaciones simbólicas que, por el significado que se les asigna quien las recibe e interpreta, contribuyen a disminuir la incertidumbre de forma que pueda decidir un curso de acción entre varios posibles.

La información se compone de un conjunto ordenado de datos relacionados que permiten tomar decisiones con el menor riesgo posible. Es importante destacar **que no todos los datos constituyen información, sino solo aquellos que tienen un significado específico para quien los recibe e interpreta y contribuyen a disminuir la incertidumbre para tomar una decisión informada.**

==*toda información consta de datos, pero no todos los datos constituyen información.*==

En resumen, la información es un conjunto ordenado de datos relacionados que permiten tomar decisiones con el menor riesgo posible. La información se compone de representaciones simbólicas que tienen un significado específico para quien las recibe e interpreta y contribuyen a disminuir la incertidumbre para tomar una decisión informada.

La información se compone de un conjunto ordenado de datos relacionados que permiten tomar decisiones con el menor riesgo posible. Es importante destacar **que no todos los datos constituyen información, sino solo aquellos que tienen un significado específico para quien los recibe e interpreta y contribuyen a disminuir la incertidumbre para tomar una decisión informada.**

==*toda información consta de datos, pero no todos los datos constituyen información.*==

En resumen, la información es un conjunto ordenado de datos relacionados que permiten tomar decisiones con el menor riesgo posible. La información se compone de representaciones simbólicas que tienen un significado específico para quien las recibe e interpreta y contribuyen a disminuir la incertidumbre para tomar una decisión informada.

4

New cards

Diferencia entre datos e información

los datos son hechos o cifras que se recopilan y almacenan, mientras que la información es el resultado del procesamiento y análisis de esos datos.

En otras palabras, los datos son elementos brutos que no tienen significado por sí mismos, mientras que la información es el resultado de dar sentido a esos datos. Por ejemplo, si se tiene una lista de números aleatorios, eso serían datos. Pero si se ordenan esos números en una secuencia lógica y se les da un contexto (por ejemplo, "esta es la lista de ventas del último mes"), entonces eso sería información. Es importante destacar que para convertir los datos en información se requiere un proceso de análisis y síntesis. Este proceso implica identificar patrones, relaciones y tendencias en los datos para poder extraer conclusiones útiles.

==*toda información consta de datos, pero no todos los datos constituyen información.*==

En resumen, la diferencia entre datos e información radica en que los primeros son elementos brutos sin significado por sí mismos, mientras que la segunda es el resultado del procesamiento y análisis de esos datos para darles sentido y extraer conclusiones útiles.

En otras palabras, los datos son elementos brutos que no tienen significado por sí mismos, mientras que la información es el resultado de dar sentido a esos datos. Por ejemplo, si se tiene una lista de números aleatorios, eso serían datos. Pero si se ordenan esos números en una secuencia lógica y se les da un contexto (por ejemplo, "esta es la lista de ventas del último mes"), entonces eso sería información. Es importante destacar que para convertir los datos en información se requiere un proceso de análisis y síntesis. Este proceso implica identificar patrones, relaciones y tendencias en los datos para poder extraer conclusiones útiles.

==*toda información consta de datos, pero no todos los datos constituyen información.*==

En resumen, la diferencia entre datos e información radica en que los primeros son elementos brutos sin significado por sí mismos, mientras que la segunda es el resultado del procesamiento y análisis de esos datos para darles sentido y extraer conclusiones útiles.

5

New cards

conceptos de Teoría de la información

En esta sección, se formalizan conceptos como datos e información, incertidumbre e información, cantidad y medida de la información, así como el teorema fundamental que establece cómo transmitir información sobre un canal con errores arbitrariamente pequeños.

En primer lugar, se distingue entre datos e información. Los datos son hechos o cifras sin contexto ni significado, mientras que la información es el resultado de procesar y dar sentido a los datos. Además, se establece una **relación entre incertidumbre e información:** ==a medida que disminuye la incertidumbre en un mensaje, aumenta la cantidad de información que contiene.==

También se formaliza el concepto de c**antidad de información a transmitir a través de un canal.** Se define como la cantidad mínima de bits necesarios para transmitir un mensaje determinado. La **medida de la información** es otro concepto clave en esta sección. Se define como un mensaje particular que debe ser formalizado para luego encontrar que cuando menor es la información en un mensaje, más rápido podemos transmitirlo. Finalmente, **se presenta el teorema fundamental de la teoría de la información**. Este teorema establece que dada una fuente de información y un canal de comunicación, existe una técnica de codificación tal que la información puede ser transmitida sobre el canal con una tasa menor que la capacidad del canal y con una frecuencia de errores arbitrariamente pequeña a pesar de la presencia de ruido.

En resumen, esta sección del PDF establece los conceptos fundamentales en teoría de la información, incluyendo datos e información, incertidumbre e información, cantidad y medida de la información, así como el teorema fundamental que establece cómo transmitir información sobre un canal con errores arbitrariamente pequeños. Estos conceptos son esenciales para comprender los capítulos posteriores del manual.

En primer lugar, se distingue entre datos e información. Los datos son hechos o cifras sin contexto ni significado, mientras que la información es el resultado de procesar y dar sentido a los datos. Además, se establece una **relación entre incertidumbre e información:** ==a medida que disminuye la incertidumbre en un mensaje, aumenta la cantidad de información que contiene.==

También se formaliza el concepto de c**antidad de información a transmitir a través de un canal.** Se define como la cantidad mínima de bits necesarios para transmitir un mensaje determinado. La **medida de la información** es otro concepto clave en esta sección. Se define como un mensaje particular que debe ser formalizado para luego encontrar que cuando menor es la información en un mensaje, más rápido podemos transmitirlo. Finalmente, **se presenta el teorema fundamental de la teoría de la información**. Este teorema establece que dada una fuente de información y un canal de comunicación, existe una técnica de codificación tal que la información puede ser transmitida sobre el canal con una tasa menor que la capacidad del canal y con una frecuencia de errores arbitrariamente pequeña a pesar de la presencia de ruido.

En resumen, esta sección del PDF establece los conceptos fundamentales en teoría de la información, incluyendo datos e información, incertidumbre e información, cantidad y medida de la información, así como el teorema fundamental que establece cómo transmitir información sobre un canal con errores arbitrariamente pequeños. Estos conceptos son esenciales para comprender los capítulos posteriores del manual.

6

New cards

Medida de la Información

La medida de la información se define como una indicación de la libertad de elección que puede tener la fuente para emitir libremente un mensaje. **Cuando hay elección, no hay incertidumbre, por lo tanto, no hay información**. ==La cantidad de información depende más de la incertidumbre del mensaje que del contenido del mismo.==

En resumen, la medida de la información es una forma de cuantificar el grado de incertidumbre en un mensaje y su capacidad para reducir esa incertidumbre.

En resumen, la medida de la información es una forma de cuantificar el grado de incertidumbre en un mensaje y su capacidad para reducir esa incertidumbre.

7

New cards

Cantidad de Información

Se establece que la información se refiere al significado de un conjunto de símbolos, mientras que la cantidad de información mide el número de símbolos necesarios para codificar un mensaje cuya probabilidad de ocurrencia es "P".

Además, se explica que el bit es la menor cantidad de información que se puede comunicar y corresponde a la determinación de un mensaje entre dos posibles, cuya probabilidad de ocurrencia es P = l/2. Es decir, cada bit recibido permite decidir una de dos alternativas posibles, codificables mediante mensaje de un solo símbolo: 1 ó 0.

**La sección también destaca que cualquier forma de información puede simbolizarse mediante bit**. Por ejemplo, si tenemos una fuente que emite cuatro mensajes diferentes con igual probabilidad (P=1/4), entonces necesitamos dos bits para transmitir cada uno (00, 01, 10 o 11). En cambio, si uno de los mensajes tiene mayor probabilidad (por ejemplo P=1/2), entonces podemos utilizar menos bits para transmitirlo.

En resumen, la sección "cantidad de información" establece los conceptos fundamentales para cuantificar **la cantidad mínima de bits** necesarios para transmitir un mensaje y cómo esta cantidad depende tanto del contenido del mensaje como su probabilidad.

Además, se explica que el bit es la menor cantidad de información que se puede comunicar y corresponde a la determinación de un mensaje entre dos posibles, cuya probabilidad de ocurrencia es P = l/2. Es decir, cada bit recibido permite decidir una de dos alternativas posibles, codificables mediante mensaje de un solo símbolo: 1 ó 0.

**La sección también destaca que cualquier forma de información puede simbolizarse mediante bit**. Por ejemplo, si tenemos una fuente que emite cuatro mensajes diferentes con igual probabilidad (P=1/4), entonces necesitamos dos bits para transmitir cada uno (00, 01, 10 o 11). En cambio, si uno de los mensajes tiene mayor probabilidad (por ejemplo P=1/2), entonces podemos utilizar menos bits para transmitirlo.

En resumen, la sección "cantidad de información" establece los conceptos fundamentales para cuantificar **la cantidad mínima de bits** necesarios para transmitir un mensaje y cómo esta cantidad depende tanto del contenido del mensaje como su probabilidad.

8

New cards

Cantidad de Información FORMULAS

se establecen las siguientes fórmulas para entender el cálculo de la cantidad de información y las fuentes:

1. Cantidad de información (I): Es la cantidad mínima de bits necesarios para transmitir un mensaje determinado. Se calcula mediante la siguiente fórmula:

### I = -log2(P)

Donde P es la probabilidad del mensaje.

2. Entropía (H): Es una medida de la incertidumbre en una fuente. Se calcula mediante la siguiente fórmula:

### H = -ΣP(x)log2(P(x))

Donde P(x) es la probabilidad del símbolo x en la fuente.

3. Redundancia (R): Es una medida de cuánta información adicional se transmite en una fuente más allá de lo necesario para transmitir el mensaje. Se calcula mediante la siguiente fórmula:

### R = Hmax - H

Donde Hmax es el máximo posible valor de entropía para una fuente dada.

En resumen, estas fórmulas son fundamentales para entender cómo se puede cuantificar y medir la cantidad mínima de bits necesarios para transmitir un mensaje, así como también cómo se puede medir la incertidumbre y redundancia en una fuente.

1. Cantidad de información (I): Es la cantidad mínima de bits necesarios para transmitir un mensaje determinado. Se calcula mediante la siguiente fórmula:

### I = -log2(P)

Donde P es la probabilidad del mensaje.

2. Entropía (H): Es una medida de la incertidumbre en una fuente. Se calcula mediante la siguiente fórmula:

### H = -ΣP(x)log2(P(x))

Donde P(x) es la probabilidad del símbolo x en la fuente.

3. Redundancia (R): Es una medida de cuánta información adicional se transmite en una fuente más allá de lo necesario para transmitir el mensaje. Se calcula mediante la siguiente fórmula:

### R = Hmax - H

Donde Hmax es el máximo posible valor de entropía para una fuente dada.

En resumen, estas fórmulas son fundamentales para entender cómo se puede cuantificar y medir la cantidad mínima de bits necesarios para transmitir un mensaje, así como también cómo se puede medir la incertidumbre y redundancia en una fuente.

9

New cards

Formula de la cantidad de Información

se define la cantidad de información como:

### I = log2(N)/E

Donde N es el número de alternativas posibles y E es el número de elementos que componen cada alternativa. Esta fórmula establece que la cantidad de información necesaria para transmitir un mensaje depende del número de alternativas posibles y del número de elementos que componen cada alternativa.

Por ejemplo, si tenemos una fuente que emite dos mensajes diferentes con igual probabilidad (P=1/2), entonces necesitamos un bit para transmitir cada uno (0 o 1). En este caso, N=2 (dos alternativas posibles) y E=1 (un elemento en cada alternativa), por lo que la cantidad de información necesaria es:

### I = log2(2)/1 = 1 bit

En cambio, si tenemos una fuente que emite cuatro mensajes diferentes con igual probabilidad (P=1/4), entonces necesitamos dos bits para transmitir cada uno (00, 01, 10 o 11). En este caso, N=4 (cuatro alternativas posibles) y E=2 (dos elementos en cada alternativa), por lo que la cantidad de información necesaria es:

### I = log2(4)/2 = 1 bit

En resumen, la fórmula para calcular la cantidad de información establece cómo se puede cuantificar la cantidad mínima de bits necesarios para transmitir un mensaje en función del número de alternativas posibles y el número de elementos en cada alternativa.

### I = log2(N)/E

Donde N es el número de alternativas posibles y E es el número de elementos que componen cada alternativa. Esta fórmula establece que la cantidad de información necesaria para transmitir un mensaje depende del número de alternativas posibles y del número de elementos que componen cada alternativa.

Por ejemplo, si tenemos una fuente que emite dos mensajes diferentes con igual probabilidad (P=1/2), entonces necesitamos un bit para transmitir cada uno (0 o 1). En este caso, N=2 (dos alternativas posibles) y E=1 (un elemento en cada alternativa), por lo que la cantidad de información necesaria es:

### I = log2(2)/1 = 1 bit

En cambio, si tenemos una fuente que emite cuatro mensajes diferentes con igual probabilidad (P=1/4), entonces necesitamos dos bits para transmitir cada uno (00, 01, 10 o 11). En este caso, N=4 (cuatro alternativas posibles) y E=2 (dos elementos en cada alternativa), por lo que la cantidad de información necesaria es:

### I = log2(4)/2 = 1 bit

En resumen, la fórmula para calcular la cantidad de información establece cómo se puede cuantificar la cantidad mínima de bits necesarios para transmitir un mensaje en función del número de alternativas posibles y el número de elementos en cada alternativa.

10

New cards

Información Mutua

La información mutua se define en función de los mensajes individuales o símbolos que una fuente puede producir.

La aplicación de la información mutua se encuentra en diversas áreas, como en el procesamiento de señales, el aprendizaje automático y la teoría de la comunicación. Por ejemplo, en el procesamiento de señales, se puede utilizar para determinar cuánta información se transmite a través de un canal ruidoso.

La información mutua trata de la probabilidad de que un mensaje sea elegido para su transmisión. Dada una fuente que produce varios mensajes (A, B, C, D) en transmisión independiente, la información mutua del mensaje A estaría dada por:

i(A) = f((P_(A))), donde f((P_(A))) = log b 1/PA.

La fórmula para calcular la información mutua se basa en la probabilidad de que un mensaje sea transmitido y se expresa en términos de bits.

Cuando el mensaje "A" es entregado al usuario, este recibe "1^a" unidades de información. Si se entrega un segundo mensaje (B), la información total recibida debería ser la suma de las informaciones mutuas: I = I_A + I_B. Esto es fácil de ver si consideramos que "A" y "B" vienen de diferentes fuentes. Pero si "A" y "B" provienen de la misma fuente y son estadísticamente independientes, podemos hablar entonces del mensaje compuesto: C = AB. En este caso, si P_C = P_A \* P_B, entonces I_C = f(P_A \* P_B).

La aplicación de la información mutua se encuentra en diversas áreas, como en el procesamiento de señales, el aprendizaje automático y la teoría de la comunicación. Por ejemplo, en el procesamiento de señales, se puede utilizar para determinar cuánta información se transmite a través de un canal ruidoso.

La información mutua trata de la probabilidad de que un mensaje sea elegido para su transmisión. Dada una fuente que produce varios mensajes (A, B, C, D) en transmisión independiente, la información mutua del mensaje A estaría dada por:

i(A) = f((P_(A))), donde f((P_(A))) = log b 1/PA.

La fórmula para calcular la información mutua se basa en la probabilidad de que un mensaje sea transmitido y se expresa en términos de bits.

Cuando el mensaje "A" es entregado al usuario, este recibe "1^a" unidades de información. Si se entrega un segundo mensaje (B), la información total recibida debería ser la suma de las informaciones mutuas: I = I_A + I_B. Esto es fácil de ver si consideramos que "A" y "B" vienen de diferentes fuentes. Pero si "A" y "B" provienen de la misma fuente y son estadísticamente independientes, podemos hablar entonces del mensaje compuesto: C = AB. En este caso, si P_C = P_A \* P_B, entonces I_C = f(P_A \* P_B).

11

New cards

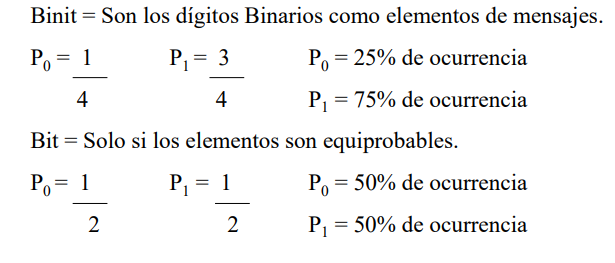

Binit y Bit

Los términos "bit" y "binit" en el contexto de la teoría de la información. Un bit es la unidad básica de información que se utiliza para medir la cantidad de información contenida en un mensaje. Se define como la cantidad de información necesaria para elegir entre dos opciones igualmente probables. Por ejemplo, si se lanza una moneda al aire, hay dos posibles resultados igualmente probables: cara o cruz. La elección entre estas dos opciones requiere un bit de información.

Por otro lado, un binit es una unidad de medida que representa una elección entre dos opciones desiguales. Si hay n opciones desiguales, entonces se necesitan log2(n) binits para elegir entre ellas. Por ejemplo, si se tiene una baraja española con 40 cartas y se extrae una carta al azar, entonces se necesitan log2(40) = 5.32 binits para especificar cuál carta fue seleccionada.

\

En resumen, un bit es la unidad básica de información que mide la cantidad de información necesaria para elegir entre dos opciones igualmente probables, mientras que un binit mide la cantidad de información necesaria para elegir entre dos opciones desiguales.

Por otro lado, un binit es una unidad de medida que representa una elección entre dos opciones desiguales. Si hay n opciones desiguales, entonces se necesitan log2(n) binits para elegir entre ellas. Por ejemplo, si se tiene una baraja española con 40 cartas y se extrae una carta al azar, entonces se necesitan log2(40) = 5.32 binits para especificar cuál carta fue seleccionada.

\

En resumen, un bit es la unidad básica de información que mide la cantidad de información necesaria para elegir entre dos opciones igualmente probables, mientras que un binit mide la cantidad de información necesaria para elegir entre dos opciones desiguales.

12

New cards

Entropía- Información promedio

Aunque el flujo de información instantáneo de una fuente puede ser errático, es necesario definir la fuente en términos de la información promedio. La información promedio se refiere a la cantidad media de información contenida en los mensajes producidos por una fuente. Esta cantidad se mide en bits y se calcula utilizando la entropía de la fuente, que es una medida de su incertidumbre o imprevisibilidad.

La fórmula para calcular la entropía H(S) de una fuente S con **n** símbolos posibles y probabilidades p1, p2,..., pn es:

H(S) = -p1 log2(p1) - p2 log2(p2) - ... - pn log2(pn)

Esta fórmula satisface las condiciones para una función logarítmica y se utiliza para calcular la cantidad media de información contenida en los mensajes producidos por una fuente. Cuanto mayor sea la entropía, mayor será la incertidumbre o imprevisibilidad de los mensajes producidos por la fuente y, por lo tanto, mayor será la cantidad media de información necesaria para representarlos.

En resumen, una explicación clara sobre cómo calcular la información promedio utilizando la entropía de una fuente. La fórmula para calcular esta cantidad se basa en las probabilidades asociadas con cada símbolo posible producido por la fuente

La fórmula para calcular la entropía H(S) de una fuente S con **n** símbolos posibles y probabilidades p1, p2,..., pn es:

H(S) = -p1 log2(p1) - p2 log2(p2) - ... - pn log2(pn)

Esta fórmula satisface las condiciones para una función logarítmica y se utiliza para calcular la cantidad media de información contenida en los mensajes producidos por una fuente. Cuanto mayor sea la entropía, mayor será la incertidumbre o imprevisibilidad de los mensajes producidos por la fuente y, por lo tanto, mayor será la cantidad media de información necesaria para representarlos.

En resumen, una explicación clara sobre cómo calcular la información promedio utilizando la entropía de una fuente. La fórmula para calcular esta cantidad se basa en las probabilidades asociadas con cada símbolo posible producido por la fuente

13

New cards

Tasa de Información

Se refiere a la cantidad de información que se puede transmitir por unidad de tiempo a través de un canal. La tasa de información se mide en bits por segundo (bps) y depende del ancho de banda del canal y del nivel de ruido presente en el mismo.

La tasa de información es una medida importante en la teoría de la comunicación, ya que permite determinar cuánta información se puede transmitir eficientemente a través de un canal dado. Para maximizar la tasa de información, es necesario utilizar técnicas como la codificación eficiente y la corrección de errores para reducir el nivel de ruido y aumentar el ancho de banda disponible.

En resumen, la tasa de información es una medida importante en la teoría de la comunicación que indica cuánta información se puede transmitir por unidad de tiempo a través de un canal. Esta medida depende del ancho de banda del canal y del nivel de ruido presente en el mismo, y para maximizarla es necesario utilizar técnicas como la codificación eficiente y la corrección de errores.

*“la medida de la información está relacionada con la incertidumbre. Hay que destacar que la cantidad de información depende más de la incertidumbre del mensaje que del contenido del mismo. La medida de la información es una indicación de la libertad de elección que puede tener la fuente puede emitir libremente un mensaje, el receptor tiene alta incertidumbre respecto al mensaje que será seleccionado. Pero si hay elección, no hay incertidumbre, por lo tanto no hay información”*

La tasa de información es una medida importante en la teoría de la comunicación, ya que permite determinar cuánta información se puede transmitir eficientemente a través de un canal dado. Para maximizar la tasa de información, es necesario utilizar técnicas como la codificación eficiente y la corrección de errores para reducir el nivel de ruido y aumentar el ancho de banda disponible.

En resumen, la tasa de información es una medida importante en la teoría de la comunicación que indica cuánta información se puede transmitir por unidad de tiempo a través de un canal. Esta medida depende del ancho de banda del canal y del nivel de ruido presente en el mismo, y para maximizarla es necesario utilizar técnicas como la codificación eficiente y la corrección de errores.

*“la medida de la información está relacionada con la incertidumbre. Hay que destacar que la cantidad de información depende más de la incertidumbre del mensaje que del contenido del mismo. La medida de la información es una indicación de la libertad de elección que puede tener la fuente puede emitir libremente un mensaje, el receptor tiene alta incertidumbre respecto al mensaje que será seleccionado. Pero si hay elección, no hay incertidumbre, por lo tanto no hay información”*

14

New cards

Tasa de información | formula + ejemplo

La fórmula para calcular la tasa de información es:

R = H / o \[bits/seg\]

Donde R es la tasa de información en bits por segundo, H es la entropía de la fuente y o es la duración promedio del símbolo.

Un ejemplo concreto para entender mejor este concepto podría ser el siguiente: supongamos que tenemos una fuente que emite símbolos binarios (0 o 1) con igual probabilidad y una duración promedio del símbolo de 1 segundo. La entropía de esta fuente sería H = -0.5\*log2(0.5) - 0.5\*log2(0.5) = 1 bit, ya que hay dos posibles símbolos equiprobables.

Si queremos calcular la tasa de información para esta fuente, podemos utilizar la fórmula anterior:

R = H / o = 1 bit / 1 seg = 1 bit/seg

Esto significa que podemos transmitir un bit por segundo a través del canal utilizando esta fuente.

Otro ejemplo podría ser una señal analógica que se muestrea y cuantifica para su transmisión digital. En este caso, la tasa de información dependerá del número de bits utilizados para cuantificar cada muestra y del número de muestras transmitidas por segundo.

En resumen, la tasa de información es una medida importante en la teoría de la comunicación que indica cuánta información se puede transmitir por unidad de tiempo a través de un canal. Se calcula utilizando la fórmula R = H / o, donde H es la entropía de la fuente y o es la duración promedio del símbolo. Ejemplos concretos de tasa de información incluyen fuentes binarias y señales analógicas muestreadas y cuantificadas.

R = H / o \[bits/seg\]

Donde R es la tasa de información en bits por segundo, H es la entropía de la fuente y o es la duración promedio del símbolo.

Un ejemplo concreto para entender mejor este concepto podría ser el siguiente: supongamos que tenemos una fuente que emite símbolos binarios (0 o 1) con igual probabilidad y una duración promedio del símbolo de 1 segundo. La entropía de esta fuente sería H = -0.5\*log2(0.5) - 0.5\*log2(0.5) = 1 bit, ya que hay dos posibles símbolos equiprobables.

Si queremos calcular la tasa de información para esta fuente, podemos utilizar la fórmula anterior:

R = H / o = 1 bit / 1 seg = 1 bit/seg

Esto significa que podemos transmitir un bit por segundo a través del canal utilizando esta fuente.

Otro ejemplo podría ser una señal analógica que se muestrea y cuantifica para su transmisión digital. En este caso, la tasa de información dependerá del número de bits utilizados para cuantificar cada muestra y del número de muestras transmitidas por segundo.

En resumen, la tasa de información es una medida importante en la teoría de la comunicación que indica cuánta información se puede transmitir por unidad de tiempo a través de un canal. Se calcula utilizando la fórmula R = H / o, donde H es la entropía de la fuente y o es la duración promedio del símbolo. Ejemplos concretos de tasa de información incluyen fuentes binarias y señales analógicas muestreadas y cuantificadas.

15

New cards

T I+ ejemplo

Ejemplo 1: Calcular la información asociada a la caída de una moneda (suceso estadísticamente independiente).

Para calcular la información asociada a la caída de una moneda, se debe primero determinar la entropía de la fuente. En este caso, como hay dos posibles resultados equiprobables (cara o cruz), la entropía es H = log2(2) = 1 bit.

Por lo tanto, la información asociada a cada lanzamiento de moneda es 1 bit.

Ejemplo 2: Supongamos que dos fuentes tienen la misma entropía, pero una es más rápida que la otra, es decir, produce más símbolos por unidad de tiempo.

En este ejemplo, se menciona que dos fuentes tienen la misma entropía pero producen diferentes cantidades de símbolos por unidad de tiempo. Para calcular su tasa de información media en bits por segundo "bpsé", se utiliza la fórmula R = H / o \[bits/seg\], donde H es la entropía y o es la duración promedio del símbolo. La fuente más rápida tendrá una tasa de información mayor que la fuente más lenta.

Ejemplo 9: Un sistema de facsímil transmite una imagen que tiene 250 líneas horizontales y 200 puntos por líneas. Si cada punto puede tomar 32 niveles equiprobable de brillo, calcular la cantidad de información de la imagen.

Para calcular la cantidad de información en esta imagen, se debe primero determinar el número total de posibles combinaciones entre los niveles equiprobables del brillo en cada punto. En este caso, hay 32 posibles niveles para cada punto y hay un total de

**250 x 200 = 50,000** puntos en la imagen. Por lo tanto, el número total de posibles combinaciones es **32^50000.** Para calcular la cantidad de información, se utiliza la fórmula **I = log2(N)**, donde N es el número de posibles combinaciones. En este caso**, I = log2(32^50000) = 166,096 bits**. Por lo tanto, la cantidad de información en esta imagen es de 166,096 bits.

250 \* 200 = 50000

I = log2 N E = log2 3250000 = 50.000 \* log2 32 =

= 50.000 \* 5 = 250.000 \[bit1\]

Para calcular la información asociada a la caída de una moneda, se debe primero determinar la entropía de la fuente. En este caso, como hay dos posibles resultados equiprobables (cara o cruz), la entropía es H = log2(2) = 1 bit.

Por lo tanto, la información asociada a cada lanzamiento de moneda es 1 bit.

Ejemplo 2: Supongamos que dos fuentes tienen la misma entropía, pero una es más rápida que la otra, es decir, produce más símbolos por unidad de tiempo.

En este ejemplo, se menciona que dos fuentes tienen la misma entropía pero producen diferentes cantidades de símbolos por unidad de tiempo. Para calcular su tasa de información media en bits por segundo "bpsé", se utiliza la fórmula R = H / o \[bits/seg\], donde H es la entropía y o es la duración promedio del símbolo. La fuente más rápida tendrá una tasa de información mayor que la fuente más lenta.

Ejemplo 9: Un sistema de facsímil transmite una imagen que tiene 250 líneas horizontales y 200 puntos por líneas. Si cada punto puede tomar 32 niveles equiprobable de brillo, calcular la cantidad de información de la imagen.

Para calcular la cantidad de información en esta imagen, se debe primero determinar el número total de posibles combinaciones entre los niveles equiprobables del brillo en cada punto. En este caso, hay 32 posibles niveles para cada punto y hay un total de

**250 x 200 = 50,000** puntos en la imagen. Por lo tanto, el número total de posibles combinaciones es **32^50000.** Para calcular la cantidad de información, se utiliza la fórmula **I = log2(N)**, donde N es el número de posibles combinaciones. En este caso**, I = log2(32^50000) = 166,096 bits**. Por lo tanto, la cantidad de información en esta imagen es de 166,096 bits.

250 \* 200 = 50000

I = log2 N E = log2 3250000 = 50.000 \* log2 32 =

= 50.000 \* 5 = 250.000 \[bit1\]

16

New cards

Obtención de la Información

La obtención de la información es un proceso que implica la recopilación, procesamiento y análisis de datos para obtener nueva información útil y relevante. La información se puede obtener a través de diversas vías, como la observación directa, la investigación o el análisis de datos históricos. El proceso de datos es fundamental en este proceso, ya que permite transformar los datos en información útil mediante operaciones específicas como el cálculo, el ordenamiento o la traducción. Una vez obtenida la información deseada, esta debe ser analizada y evaluada para determinar su relevancia y utilidad.

para llevar a cabo una acción es necesario contar con información descriptiva que permita conocer las acciones necesarias y su secuencia. La información se puede obtener a través de procesos de datos, los cuales permiten transformar los datos primarios en información útil mediante operaciones específicas como el cálculo, el ordenamiento o la traducción. Los datos resultantes de un proceso, convenientemente ordenados, representan información para quien les asigne una significación que permita encarar una decisión. Además, se destaca que cualquier proceso, ya sea industrial, biológico, químico o físico, supone materias primas específicas (entradas) que serán transformadas para lograr un cierto producto requerido (salida).

para llevar a cabo una acción es necesario contar con información descriptiva que permita conocer las acciones necesarias y su secuencia. La información se puede obtener a través de procesos de datos, los cuales permiten transformar los datos primarios en información útil mediante operaciones específicas como el cálculo, el ordenamiento o la traducción. Los datos resultantes de un proceso, convenientemente ordenados, representan información para quien les asigne una significación que permita encarar una decisión. Además, se destaca que cualquier proceso, ya sea industrial, biológico, químico o físico, supone materias primas específicas (entradas) que serán transformadas para lograr un cierto producto requerido (salida).

17

New cards

Ob-Información | procesos de datos

el proceso de recopilación, procesamiento y análisis de datos para obtener nueva información útil y relevante. La información puede ser obtenida a través de tres vías: observación directa, investigación o análisis de datos históricos. __La percepción de fenómenos naturales y la codificación de lenguajes creados por hombres son dos formas en las que se pueden obtener datos primarios para su posterior procesamiento.__ Los procesos de datos son el medio para obtener nuevos datos a partir de otros mediante operaciones específicas como el cálculo, el ordenamiento o la traducción. Estos procesos tienen entradas y salidas, una estructura compuesta por elementos y relaciones entre ellos, y pueden ser realizados mediante cómputo utilizando algoritmos. Los procesos pueden ser secuenciales o concurrentes dependiendo del tipo de operaciones que se realicen.

@@Estos procesos tienen entradas y salidas, una estructura compuesta por elementos y relaciones entre ellos, y pueden ser realizados mediante cómputo utilizando algoritmos.@@

@@Las entradas son los datos primarios que se utilizan como base para realizar las operaciones necesarias para obtener nuevos datos. Las salidas son los resultados obtenidos después de aplicar las operaciones a las entradas. La estructura se refiere a la organización de los elementos que conforman los datos, mientras que las relaciones se refieren a las conexiones entre estos elementos.@@

@@El cómputo es el proceso de efectuar operaciones con el objeto de obtener un resultado. Los algnbvcoritmos son una serie de instrucciones lógicas que permiten realizar un proceso determinado. Los procesos pueden ser secuenciales o concurrentes dependiendo del tipo de operaciones que se realicen.@@

En resumen, la obtención de la información es un proceso clave que involucra la percepción de fenómenos naturales, la codificación de lenguajes creados por hombres y los procesos de datos para transformar los datos primarios en información útil mediante operaciones específicas.

Los procesos de datos permiten transformar los datos primarios en información útil y relevante para la toma de decisiones informadas. Estos procesos pueden ser realizados manualmente o mediante sistemas automatizados como programas informáticos diseñados específicamente para realizar estas tareas. En cualquier caso, es importante tener en cuenta que la calidad y precisión de los resultados obtenidos dependerá en gran medida del diseño y ejecución adecuada del proceso de datos utilizado.

@@Estos procesos tienen entradas y salidas, una estructura compuesta por elementos y relaciones entre ellos, y pueden ser realizados mediante cómputo utilizando algoritmos.@@

@@Las entradas son los datos primarios que se utilizan como base para realizar las operaciones necesarias para obtener nuevos datos. Las salidas son los resultados obtenidos después de aplicar las operaciones a las entradas. La estructura se refiere a la organización de los elementos que conforman los datos, mientras que las relaciones se refieren a las conexiones entre estos elementos.@@

@@El cómputo es el proceso de efectuar operaciones con el objeto de obtener un resultado. Los algnbvcoritmos son una serie de instrucciones lógicas que permiten realizar un proceso determinado. Los procesos pueden ser secuenciales o concurrentes dependiendo del tipo de operaciones que se realicen.@@

En resumen, la obtención de la información es un proceso clave que involucra la percepción de fenómenos naturales, la codificación de lenguajes creados por hombres y los procesos de datos para transformar los datos primarios en información útil mediante operaciones específicas.

Los procesos de datos permiten transformar los datos primarios en información útil y relevante para la toma de decisiones informadas. Estos procesos pueden ser realizados manualmente o mediante sistemas automatizados como programas informáticos diseñados específicamente para realizar estas tareas. En cualquier caso, es importante tener en cuenta que la calidad y precisión de los resultados obtenidos dependerá en gran medida del diseño y ejecución adecuada del proceso de datos utilizado.

18

New cards

Fuentes Continuas

son aquellas cuyos mensajes son funcionales y varían continuamente con el tiempo. A diferencia de las fuentes discretas, la definición de entropía para fuentes continuas es muy compleja y escapa a los conceptos de la materia. Sin embargo, por razones de simplicidad, en la mayoría de los casos se aplica la presentación discreta.

En el caso de una fuente continua, la información que se dispone son señales analógicas que varían continuamente en el tiempo. Para representar estas señales en un sistema digital, es necesario muestrearlas y cuantificarlas en intervalos discretos de tiempo. La cantidad de bits necesarios para representar cada muestra depende del número de niveles cuantificados.

La fórmula para calcular la entropía H(X) de una fuente continua X con densidad de probabilidad p(x) es:

H(X) = -∫p(x) log2(p(x)) dx

Esta fórmula se utiliza para calcular la cantidad media de información contenida en cada muestra producida por una fuente continua. Cuanto mayor sea la entropía, mayor será la incertidumbre o imprevisibilidad asociada con cada muestra producida por la fuente continua.

En resumen, una explicación clara sobre las fuentes continuas y cómo se pueden representar sus señales analógicas en sistemas digitales mediante muestreo y cuantificación. También se presenta una fórmula para calcular la entropía asociada con estas señales analógicas.

En el caso de una fuente continua, la información que se dispone son señales analógicas que varían continuamente en el tiempo. Para representar estas señales en un sistema digital, es necesario muestrearlas y cuantificarlas en intervalos discretos de tiempo. La cantidad de bits necesarios para representar cada muestra depende del número de niveles cuantificados.

La fórmula para calcular la entropía H(X) de una fuente continua X con densidad de probabilidad p(x) es:

H(X) = -∫p(x) log2(p(x)) dx

Esta fórmula se utiliza para calcular la cantidad media de información contenida en cada muestra producida por una fuente continua. Cuanto mayor sea la entropía, mayor será la incertidumbre o imprevisibilidad asociada con cada muestra producida por la fuente continua.

En resumen, una explicación clara sobre las fuentes continuas y cómo se pueden representar sus señales analógicas en sistemas digitales mediante muestreo y cuantificación. También se presenta una fórmula para calcular la entropía asociada con estas señales analógicas.

19

New cards

Modelos de comunicación

1\. Modelo de fuente discreta sin memoria:\[TELETIPOS\] Este modelo se utiliza para describir fuentes discretas que producen símbolos independientes entre sí. La entropía H(X) de una fuente discreta sin memoria se puede calcular utilizando la siguiente fórmula:

a) Cada símbolo o letra no depende del anterior.

b) Todos los símbolos o letras son equiprobables.

H(X) = - ∑ p(x) log2 p(x)

donde p(x) es la probabilidad de ocurrencia del símbolo x en la fuente.

Por ejemplo, si tenemos una fuente que produce los símbolos {A, B, C} con probabilidades {0.4, 0.3, 0.3}, entonces la entropía H(X) de la fuente sería:

H(X) = - (0.4 log2 0.4 + 0.3 log2 0.3 + 0.3 log2 0.3) = 1.5709 bits/símbolo

\

Esto significa que cada símbolo producido por la fuente contiene en promedio 1.5709 bits de información.

Los cinco modelos desarrollados por Claude Shannon para describir diferentes aspectos del proceso de comunicación, desde la producción del mensaje hasta su transmisión a través del canal y su recepción por el destinatario final.

\

a) Cada símbolo o letra no depende del anterior.

b) Todos los símbolos o letras son equiprobables.

H(X) = - ∑ p(x) log2 p(x)

donde p(x) es la probabilidad de ocurrencia del símbolo x en la fuente.

Por ejemplo, si tenemos una fuente que produce los símbolos {A, B, C} con probabilidades {0.4, 0.3, 0.3}, entonces la entropía H(X) de la fuente sería:

H(X) = - (0.4 log2 0.4 + 0.3 log2 0.3 + 0.3 log2 0.3) = 1.5709 bits/símbolo

\

Esto significa que cada símbolo producido por la fuente contiene en promedio 1.5709 bits de información.

Los cinco modelos desarrollados por Claude Shannon para describir diferentes aspectos del proceso de comunicación, desde la producción del mensaje hasta su transmisión a través del canal y su recepción por el destinatario final.

\

20

New cards

Modelos de comunicación 2

2\. Modelo de canal con ruido aditivo blanco: Este modelo se utiliza para describir canales que transmiten información con ruido aditivo blanco gaussiano. Un ejemplo podría ser la transmisión de señales de televisión o radio a través del aire.

a) Cada símbolo o letra no depende del anterior.

b) Consideremos a los símbolos con su probabilidad de aparición

a) Cada símbolo o letra no depende del anterior.

b) Consideremos a los símbolos con su probabilidad de aparición

21

New cards

Modelos de comunicación 3

3\. Modelo de canal sin ruido: \[**comunicaciones espaciales**\] Este modelo se utiliza para describir canales que transmiten información con ruido aleatorio. Un ejemplo podría ser la comunicación submarina, donde las señales pueden verse afectadas por el movimiento del agua.

a) Cada letra depende solamente del último símbolo transmitido.

b) Probabilidades reales.

En este caso la entropía sigue bajando y vale: H = 3,32 bit/símbolo

a) Cada letra depende solamente del último símbolo transmitido.

b) Probabilidades reales.

En este caso la entropía sigue bajando y vale: H = 3,32 bit/símbolo

22

New cards

Modelos de comunicación 4

4\. Modelo de canal con interferencia: \[**comunicaciones espaciales**\] Este modelo se utiliza para describir canales que transmiten información con interferencia. Un ejemplo podría ser la transmisión inalámbrica en una ciudad densamente poblada, donde hay muchos dispositivos electrónicos cercanos que pueden causar interferencia.

La entropía es más baja y vales:

H = 3,10 bit/símbolo

La entropía es más baja y vales:

H = 3,10 bit/símbolo

23

New cards

Modelos de Comunicación 5

5\. modelo de canal con interferencia: se utiliza para describir canales que transmiten información con interferencia. En este modelo, la señal transmitida se ve afectada por una señal interferente que puede ser causada por otros dispositivos electrónicos cercanos o por la propagación de la señal a través de obstáculos físicos.

La capacidad de un canal se define como la máxima tasa de transmisión de información que se puede lograr con una probabilidad de error arbitrariamente pequeña.

a) Conozco todo el texto anterior.

b) Probabilidades reales.

En este caso la entropía vale: H = 1 bit/símbolo.

\-Modelo de canal con interferencia (Modelo 5): Este modelo se utiliza para describir canales que transmiten información con interferencia. La interferencia puede ser causada por otros dispositivos electrónicos cercanos o por obstáculos físicos, lo que puede afectar la calidad de la señal y aumentar la probabilidad de errores en la transmisión. El modelo 5 es útil para entender cómo se comportan los sistemas de comunicación en entornos ruidosos y cómo se pueden diseñar sistemas más robustos para manejar la interferencia.

La capacidad de un canal se define como la máxima tasa de transmisión de información que se puede lograr con una probabilidad de error arbitrariamente pequeña.

a) Conozco todo el texto anterior.

b) Probabilidades reales.

En este caso la entropía vale: H = 1 bit/símbolo.

\-Modelo de canal con interferencia (Modelo 5): Este modelo se utiliza para describir canales que transmiten información con interferencia. La interferencia puede ser causada por otros dispositivos electrónicos cercanos o por obstáculos físicos, lo que puede afectar la calidad de la señal y aumentar la probabilidad de errores en la transmisión. El modelo 5 es útil para entender cómo se comportan los sistemas de comunicación en entornos ruidosos y cómo se pueden diseñar sistemas más robustos para manejar la interferencia.

24

New cards

conceptos importantes

Capacidad del canal: La capacidad del canal es una medida de la máxima tasa de transmisión de información que se puede lograr con una probabilidad de error arbitrariamente pequeña. La capacidad depende del modelo del canal y se puede calcular utilizando la fórmula de Shannon. En general, cuanto mayor sea el ancho de banda del canal y menor sea el nivel de ruido, mayor será su capacidad.

Fórmula de Shannon: La fórmula de Shannon establece una relación entre la tasa de transmisión, el ancho de banda y el ruido en el canal. Esta fórmula es importante porque permite calcular la capacidad del canal y determinar cuál es la tasa máxima teórica a la cual se puede transmitir información a través del canal sin errores. La fórmula también muestra cómo diferentes factores como el ancho de banda y el nivel de ruido afectan la capacidad del canal.

Fórmula de Shannon: La fórmula de Shannon establece una relación entre la tasa de transmisión, el ancho de banda y el ruido en el canal. Esta fórmula es importante porque permite calcular la capacidad del canal y determinar cuál es la tasa máxima teórica a la cual se puede transmitir información a través del canal sin errores. La fórmula también muestra cómo diferentes factores como el ancho de banda y el nivel de ruido afectan la capacidad del canal.

25

New cards

Ley Shannon - Hartley

La Ley de Shannon es una teoría matemática de las comunicaciones desarrollada por Claude Shannon en 1948. Esta ley establece que existe una relación entre la cantidad de información que se transmite a través de un canal y su ancho de banda. La ley también establece que existe una tasa máxima teórica a la cual se puede transmitir información a través del canal sin errores. En general, cuanto mayor sea el ancho de banda del canal, mayor será la cantidad de información que se puede transmitir a través de él. La Ley de Shannon es importante porque proporciona una base teórica para entender cómo funcionan los sistemas de comunicación y cómo se pueden diseñar sistemas más eficientes para transmitir información.

*Dada una Fuente de información y un canal de comunicación, existe una técnica de codificación tal que la información puede ser transmitida sobre el canal y con una frecuencia de errores arbitrariamente pequeña a pesar de la presencia de ruido”*

los problemas que plantea tiene que ver con: la cantidad de información, la capacidad del canal de comunicación, el proceso de codificación que puede usarse para cambiar el mensaje en una señal y los efectos del “**ruido**“.

*Dada una Fuente de información y un canal de comunicación, existe una técnica de codificación tal que la información puede ser transmitida sobre el canal y con una frecuencia de errores arbitrariamente pequeña a pesar de la presencia de ruido”*

los problemas que plantea tiene que ver con: la cantidad de información, la capacidad del canal de comunicación, el proceso de codificación que puede usarse para cambiar el mensaje en una señal y los efectos del “**ruido**“.